Après l’échec du « Safe Harbor » et celui du « Privacy Shield », un nouvel accord se fait attendre entre l’Union européenne et les Etats-Unis sur le transfert des données à caractère personnel. Si le processus est incontestablement en cours, il suscite des réserves qui compromettent son aboutissement.

Par Emmanuelle Mignon, avocat associé, et Gaël Trouiller, avocat, August Debouzy

(Article paru le 26-06-23 dans EM@

n°302. Le 03-07-23, les Etats-Unis ont déclaré avoir « rempli leurs engagements » pour la protection des données UE-US. Le 10-07-23, la Commission européenne a publié sa décision d’adéquation)

En mars 2022, la Commission européenne avait annoncé qu’un accord politique entre sa présidente Ursula von der Leyen et le président des Etats-Unis Joe Biden avait été trouvé (

1) : une première traduction juridique de cet accord, intitulé « Data Privacy Framework » (DPF) est alors née, le 7 octobre 2022, du décret présidentiel américain – Executive Order n°14086 – sur « le renforcement des garanties relatives aux activités de renseignement sur les transmissions des Etats-Unis » (

2).

Après l’annulation du « Privacy Shield »

Sur le fondement de cet Executive Order (EO), la Commission européenne a publié, le 13 décembre 2022 (

3), un projet de décision d’adéquation du système étasunien de protection des données au droit de l’Union européenne (UE). Celui-ci a fait l’objet d’un avis consultatif du Comité européen de la protection des données (CEPD) du 28 février dernier. Cet avis reconnaît que l’EO apporte de « substantielles améliorations », mais souligne cependant que des écueils subsistent et que des clarifications du régime américain demeurent nécessaires (

4). Plus critique, le Parlement européen, dans sa résolution du 11 mai 2023, « conclut que le cadre de protection des données UE–Etats-Unis ne crée [toujours] pas d’équivalence substantielle du niveau de protection [et] invite la Commission à ne pas adopter le constat d’adéquation » (

5).

Epicentre du DPF, l’EO n°14086 de Joe Biden a pour objet d’instaurer des garanties juridiques afin de prendre en considération le droit de l’UE, en particulier l’arrêt « Schrems II » de 2020. On se souvient que, par cet arrêt, la Cour de justice de l’UE (CJUE) avait jugé que :

• Le « Privacy Shield » instituait des limitations au droit à la protection des données à caractère personnel – protégé par les articles 7 et 8 de la Charte des droits fondamentaux de l’UE – méconnaissant les exigences de nécessité et de proportionnalité découlant de l’article 52 de cette même Charte. Etait en particulier visée la collecte « en vrac » de données des citoyens européens opérée par les services de renseignement étasuniens en application : de la section 702 du Foreign Intelligence Surveillance Act (FISA) de 2008, qui autorise les services de renseignement américains à adresser à un fournisseur de services de communications électroniques des directives écrites lui imposant de procurer immédiatement au gouvernement toute information ayant pour objet d’obtenir des renseignements (métadonnées et données de contenu) se rapportant à des personnes étrangères susceptibles de menacer la sécurité des EtatsUnis ; de l’Executive Order n°12333 de 1981, qui permet aux services de renseignement américains d’accéder à des données « en transit » vers les Etats-Unis, notamment aux câbles sous-marins posés sur le plancher de l’Atlantique, ainsi que de recueillir et de conserver ces données.

• Le « Privacy Shield » ne fournissait pas de voie de contestation devant un organe offrant aux citoyens européens, dont les données sont transférées vers les EtatsUnis, des garanties substantiellement équivalentes à celles requises par l’article 47 de la Charte des droits fondamentaux de l’UE consacrant le droit à un recours effectif (

6). Pour répondre aux attentes du droit de l’UE, l’EO n°14086 de Biden instaure des principes devant guider les services de renseignement américains lorsqu’ils traitent de données à caractère personnel. A cet égard, les services de renseignement doivent : respecter la vie privée et les libertés civiles indépendamment du lieu de résidence et de la nationalité des personnes dont les données sont collectées (en particulier, cette collecte ne pourra être opérée qu’à condition d’être « nécessaire » et « proportionnée » à la priorité en matière de renseignement alléguée) ; poursuivre des objectifs limitativement définis par l’EO, comme la protection contre le terrorisme ou l’espionnage, et s’écarter, en toute hypothèse, de ceux expressément exclus tels que l’entrave à la liberté d’expression.

L’Executive Order de Biden

L’EO de Biden prévoit, en outre, un mécanisme de recours à double niveau. En premier lieu, les citoyens européens pourront saisir, par l’intermédiaire d’une autorité publique désignée à cet effet, l’officier de protection des libertés publiques – Civil Liberties Protection Officer (CLPO) – d’une plainte. Ce dernier adoptera alors, s’il estime que les garanties conférées par l’EO n’ont pas été respectées, les mesures correctives appropriées comme la suppression des données illicitement récoltées. En second lieu, un appel de la décision du CLPO pourra être interjeté devant la Cour de révision de la protection des données – Data Protection Review Court (DPRC) – spécialement créée par l’EO. Elle sera composée de membres nommés en dehors du gouvernement américain et ayant une certaine expérience juridique en matière de données à caractère personnel et de sécurité nationale. La décision de cette Cour sera rendue en dernière instance et revêtue d’un caractère contraignant.

Des frictions avec le droit de l’UE

Les points persistants de friction avec le droit de l’UE qui sont mis en avant par ceux qui sont hostiles à l’adoption du DPF sont les suivants :

• La collecte « en vrac » de données à caractère personnel, bien qu’encadrée par l’EO de Biden, n’est pas entièrement prohibée et ne nécessite pas une autorisation préalable indépendante. Le recours à cette méthode peut poser une sérieuse difficulté de compatibilité avec le droit de l’UE. En effet, la CJUE voit dans la collecte généralisée et non différenciée des données une incompatibilité avec le principe de proportionnalité (

7), à tout le moins lorsqu’une telle collecte ne fait l’objet d’aucune surveillance judiciaire et n’est pas précisément et clairement encadrée (

8). Or, cet encadrement pourrait, au cas présent, faire défaut dans la mesure où il est très largement extensible par la seule volonté du Président américain qui est habilité par l’EO à modifier, secrètement, la liste des motifs sur le fondement desquels il peut être recouru à cette technique de surveillance (

9).

• Il n’est pas acquis, faute de définition dans l’EO, que les caractères « nécessaire » et « proportionné » des collectes de données aient la même signification que celle – exigeante – prévalant en droit européen.

• L’indépendance des organes de recours peut être mise en doute, bien que le système instauré par l’EO comprenne des garanties supérieures à celles antérieurement attachées au médiateur – l’Ombudsperson – du Privacy Shield. En particulier, le CLPO et la DPRC sont organiquement rattachés au pouvoir exécutif américain, n’appartiennent pas organiquement au pouvoir judiciaire et pourraient alors ne pas pouvoir être qualifiés de tribunal au sens de l’article 47 de la Charte des droits fondamentaux de l’UE. L’EO institue toutefois des garanties fonctionnelles d’indépendance à ces deux instances. Ainsi, le directeur du renseignement national ne pourra pas intervenir dans l’examen d’une plainte déposée auprès du CLPO et il lui est interdit de révoquer ce dernier pour toute mesure prise en application de l’EO. Quant à la DPRC, ses membres – qualifiés de juges – ne pourront pas recevoir d’instructions du pouvoir exécutif, ni être limogés à raison des décisions qu’ils prendront. A cet égard, on peut s’interroger mutatis mutandis sur la portée de certaines des garanties apportées par le droit des Etats membres en matière de contrôle des activités de surveillance. L’équilibre n’est pas simple à trouver, mais, s’agissant de la France, le caractère secret de la procédure de contrôle devant le Conseil d’Etat suscite à tout le moins des interrogations.

• Enfin, d’autres règlementations américaines comme le Cloud Act – régissant la communication de données dans le cadre d’enquêtes judiciaires – n’entrent pas dans le champ de l’EO. Leur application, qui n’est donc pas tempérée par les garanties instituées par ce dernier, pourrait se révéler incompatible avec le niveau de protection des données à caractère personnel en droit de l’UE. Il y a lieu toutefois de souligner que les dispositions du Cloud Act s’inscrivent dans le cadre de l’activité judiciaire des autorités américaines (poursuites et répression des infractions pénales et administratives), qui doit être clairement distinguée des activités de renseignement. Le Cloud Act offre en pratique des garanties qui n’ont rien à envier à celles du droit de l’UE et du droit des Etats membres (

10).Ces points de vigilance, non-exhaustifs, devront être scrutés avec attention tout au long de l’examen du processus d’adoption de la décision d’adéquation. Après le CEPD et le Parlement européen, c’est au tour du comité composé des représentants des Etats membres de l’UE d’émettre prochainement un avis sur le projet de la Commission européenne. A supposer qu’il y soit favorable à la majorité qualifiée de ses membres, la décision d’adéquation pourra alors être adoptée. Si la Commission européenne s’est initialement affichée plutôt confiante sur l’avènement du DPF (

11), celui-ci pourrait évidemment se retrouver grippé par une contestation de la décision d’adéquation devant le juge européen qui a déjà été annoncée par ses adversaires. En cas de succès de ce recours, l’avenir serait alors bien incertain dans la mesure où les Etats-Unis semblent être arrivés au bout de ce qu’ils sont prêts à concéder pour parvenir à un accord transatlantique sur le transfert des données qui ne se fera pas au prix d’un affaiblissement de la conception qu’ils se font de leur sécurité nationale.

Vers une 3e annulation par la CJUE ?

Il est peu de dire qu’une éventuelle annulation par la CJUE de la future troisième décision d’adéquation après celles relatives aux « Safe Harbor » (décision « Schrems I » de 2015) et au « Privacy Shield » (décision « Schrems II » de 2020), cristalliserait, de part et d’autre de l’Atlantique, des positions politiques et juridiques certainement irréconciliables. Surtout, cela prolongerait la situation d’incertitude juridique dans laquelle sont plongés les acteurs économiques qui peuvent se voir infliger de lourdes sanctions en cas de transferts transatlantiques irréguliers de données, à l’image de la société Meta condamnée, le 12 mai 2023, à une amende record de 1,2 milliard d’euros par le régulateur irlandais.

@

« Il est toujours possible d’engager une action de groupe à l’encontre de l’opérateur télécoms, via une association de consommateurs agréée. Mais il n’y a aucune certitude que Free soit condamné : se faire cambrioler ne signifie pas nécessairement qu’on a été négligent ! », a expliqué le 31 octobre à l’association 60 Millions de Consommateurs Jean-Jacques Latour (photo), directeur expertise cybersécurité pour Cybermalveillance.gouv.fr, qui assiste entre autres les victimes de hacking. Ce jour-là cet expert avait indiqué qu’un formulaire allait être mis en ligne sur ce site gouvernemental. « Le remplir permettra aux victimes d’avoir une preuve officielle à présenter à leur banque, si jamais elle rechigne à rembourser en cas d’opération non consentie », avait-il annoncé. La Commission nationale de l’informatique et des libertés (Cnil), qui a indiqué le 12 novembre que « le dossier est désormais en cours d’instruction » après « un contrôle chez l’opérateur » la semaine précédente (1), expliquait, elle aussi, – dans la version initiale d’une page web dédiée à la fuite de données chez Free et mise en ligne le 30 octobre – qu’un formulaire de plainte allait être accessible sur le site Cybermalveillance.gouv.fr.

« Il est toujours possible d’engager une action de groupe à l’encontre de l’opérateur télécoms, via une association de consommateurs agréée. Mais il n’y a aucune certitude que Free soit condamné : se faire cambrioler ne signifie pas nécessairement qu’on a été négligent ! », a expliqué le 31 octobre à l’association 60 Millions de Consommateurs Jean-Jacques Latour (photo), directeur expertise cybersécurité pour Cybermalveillance.gouv.fr, qui assiste entre autres les victimes de hacking. Ce jour-là cet expert avait indiqué qu’un formulaire allait être mis en ligne sur ce site gouvernemental. « Le remplir permettra aux victimes d’avoir une preuve officielle à présenter à leur banque, si jamais elle rechigne à rembourser en cas d’opération non consentie », avait-il annoncé. La Commission nationale de l’informatique et des libertés (Cnil), qui a indiqué le 12 novembre que « le dossier est désormais en cours d’instruction » après « un contrôle chez l’opérateur » la semaine précédente (1), expliquait, elle aussi, – dans la version initiale d’une page web dédiée à la fuite de données chez Free et mise en ligne le 30 octobre – qu’un formulaire de plainte allait être accessible sur le site Cybermalveillance.gouv.fr.

En mars 2022, la Commission européenne avait annoncé qu’un accord politique entre sa présidente Ursula von der Leyen et le président des Etats-Unis Joe Biden avait été trouvé (

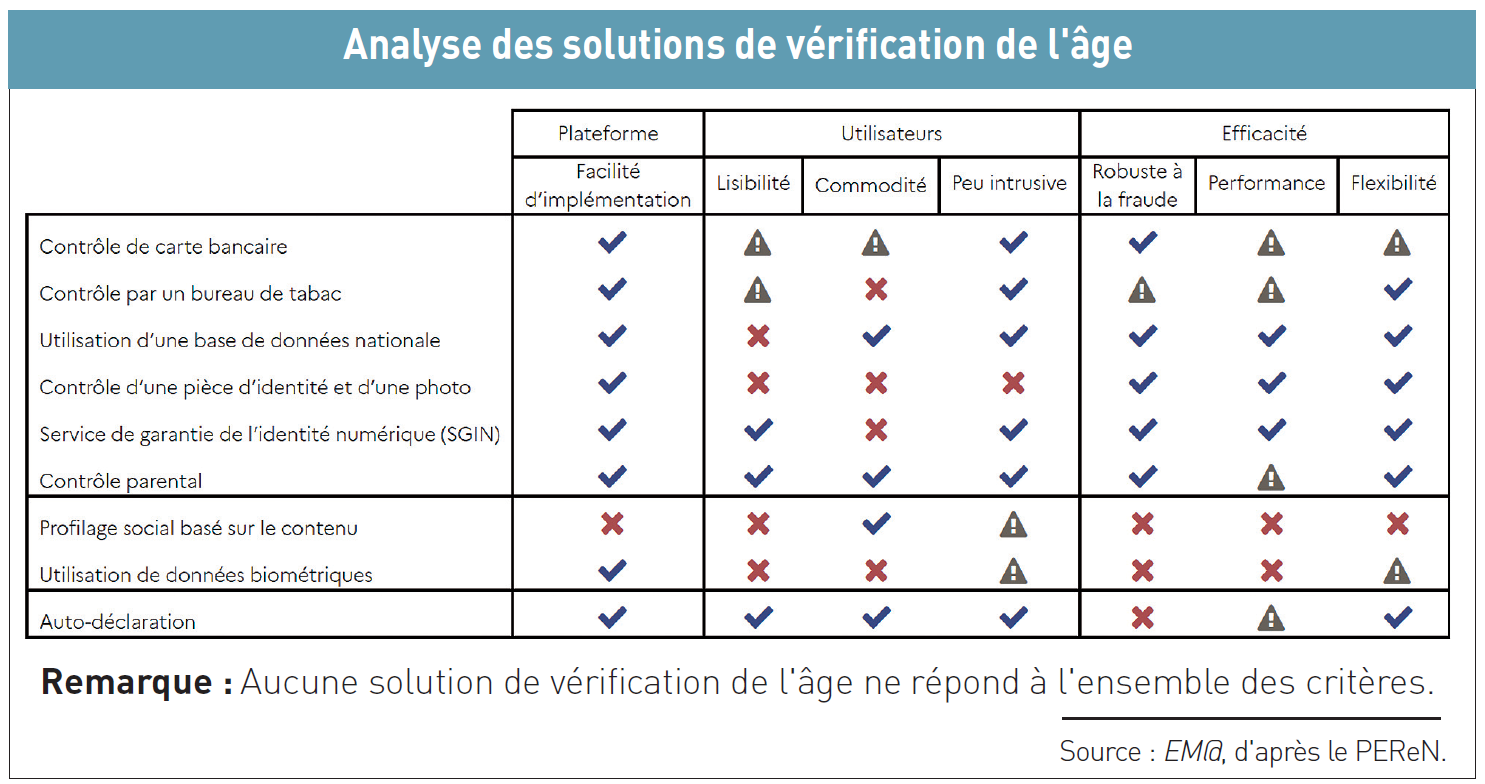

En mars 2022, la Commission européenne avait annoncé qu’un accord politique entre sa présidente Ursula von der Leyen et le président des Etats-Unis Joe Biden avait été trouvé ( Cela fait un an que la Commission nationale de l’informatique et des libertés (Cnil) a publié – le 9 juin 2021 – huit recommandations pour « renforcer la protection des mineurs en ligne » (

Cela fait un an que la Commission nationale de l’informatique et des libertés (Cnil) a publié – le 9 juin 2021 – huit recommandations pour « renforcer la protection des mineurs en ligne » (